Todo el tráfico no humano que accede a un sitio se denomina tráfico de bots.

Su sitio web eventualmente recibirá visitas de un volumen específico de bots, ya sea un sitio web de noticias conocido o una empresa de pequeña escala recientemente lanzada.

El tráfico de bots a menudo se interpreta como intrínsecamente destructivo; sin embargo, eso no siempre es cierto.

Sin duda, el comportamiento específico de un bot tiene la intención de ser hostil y puede dañar los datos.

En ocasiones, los rastreadores web se pueden utilizar para extracción de datos, ataques DDoS (denegación de servicio distribuido) o relleno de credenciales.

Estrategias probadas para identificar y eliminar el tráfico de bots

Los expertos web pueden examinar las solicitudes de acceso directo a la red a sitios web para detectar tráfico potencial de bots.

La detección del tráfico de bots también puede verse favorecida por una herramienta de análisis web incorporada. Sin embargo, primero, veamos información crucial sobre los bots antes de repasar las anomalías, que son las características distintivas de la actividad de los bots.

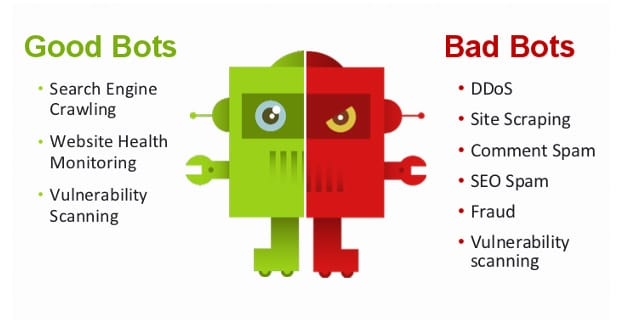

¿Qué es un buen tráfico de bots?

Los siguientes bots son confiables y existen para ofrecer respuestas beneficiosas para aplicaciones y sitios web.

1. Bots para motores de búsqueda

Los buenos bots más evidentes y populares son los robots de búsqueda web. Estos robots rastrean en línea y ayudan a los propietarios de sitios a mostrar sus sitios web en los resultados de búsqueda de Bing, Google y Yahoo. Ellos son herramientas útiles para SEO (optimización de motores de búsqueda).

2. Monitoreo de robots

Los editores pueden asegurarse de que su sitio sea seguro, utilizable y funcione al máximo mediante la supervisión de robots. Comprueban si todavía se puede acceder a un sitio web haciendo ping periódicamente.

Estos bots benefician a los propietarios de sitios, ya que notifican instantáneamente a los editores si algo funciona mal o el sitio web deja de funcionar.

3. Rastreadores de SEO

Los rastreadores de SEO utilizan algoritmos para recuperar y analizar un sitio web y sus rivales para brindar información y métricas sobre los clics en la página, los visitantes y el texto.

Posteriormente, los administradores web pueden utilizar estos conocimientos para diseñar su contenido para aumentar el rendimiento de la búsqueda orgánica y el flujo de referencias.

4. Bots de derechos de autor

Para garantizar que nadie utilice sin autorización material protegido por derechos de autor, los robots de derechos de autor buscan en línea fotografías protegidas por la ley.

¿Qué se define como tráfico de bots incorrectos?

Al contrario de los bots beneficiosos que analizamos anteriormente, la actividad de los bots dañinos puede afectar su sitio y causar un daño sustancial si no se controla.

Los resultados pueden variar desde enviar spam o engañar a los visitantes hasta cosas más disruptivas, como el fraude publicitario.

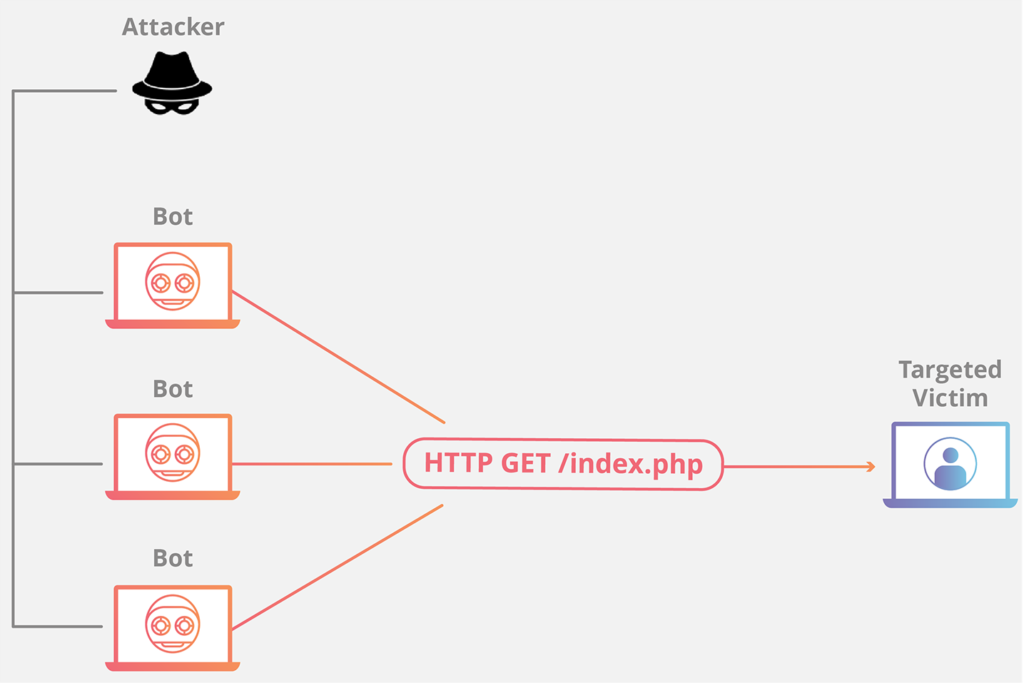

1. Redes DDoS

Entre los bots más notorios y peligrosos se encuentran los bots DDoS.

Estos programas se instalan en las computadoras de escritorio o portátiles de objetivos involuntarios y se utilizan para derribar un sitio o servidor en particular.

2. Raspadores web

Los raspadores web rastrean sitios web en busca de información valiosa, como direcciones de correo electrónico o detalles de contacto. En casos excepcionales, pueden copiar textos y fotografías de sitios y utilizarlos sin autorización en algún otro sitio web o cuenta de red social.

Muchos bots avanzados producen tráfico de bots dañino que solo se dirige a anunciantes pagos. Estos bots cometen fraude publicitario en lugar de aquellos que crean tráfico no deseado en el sitio web. Como sugiere el término, este tráfico automatizado genera visitas a anuncios pagados y cuesta significativamente a las agencias de publicidad.

Los editores tienen varias razones para emplear técnicas de detección de bots para ayudar a filtrar el tráfico ilícito, frecuentemente camuflado como tráfico normal.

3, escáneres de vulnerabilidad

Numerosos robots maliciosos escanean millones de sitios en busca de debilidades y notifican a sus desarrolladores sobre ellas. Estos bots dañinos están diseñados para comunicar datos a terceros, quienes luego pueden venderlos y utilizarlos para infiltrarse en sitios digitales, a diferencia de los bots legítimos que alertan al propietario.

4. Bots de spam

Los robots de spam están diseñados principalmente para dejar comentarios en un hilo de discusión de una página web creado por el autor del bot.

Si bien las comprobaciones CAPTCHA (Prueba pública de Turing completamente automatizada para distinguir entre computadoras y humanos) están destinadas a descartar los procesos de registro impulsados por software, es posible que no siempre sean efectivas para evitar que estos robots creen cuentas.

¿Cómo afectan los bots al rendimiento del sitio web?

Las organizaciones que no saben cómo reconocer el manejo y escanear el tráfico de los bots podrían arruinarlas.

Los sitios web que ofrecen bienes y materias primas con poca oferta y dependen de la publicidad son muy vulnerables.

Los bots que visitan sitios web con anuncios y interactúan con diferentes elementos de la página pueden provocar clics falsos en la página.

Se llama fraude de clics y, aunque al principio puede aumentar los ingresos por publicidad, una vez que las plataformas de publicidad digital identifican el fraude, el sitio web y el operador normalmente serán eliminados de su sistema.

Los robots de acaparamiento de existencias esencialmente pueden cerrar sitios web de comercio electrónico con pocas existencias al llenar los carritos con toneladas de productos, impidiendo que los clientes reales realicen compras.

Su sitio web puede ralentizarse cuando un bot le solicita datos con frecuencia. Esto implica que el sitio web se cargará lentamente para todos los usuarios, lo que podría afectar seriamente a un negocio en Internet.

En casos extremos, la actividad excesiva de los bots puede hacer que todo su sitio web caiga.

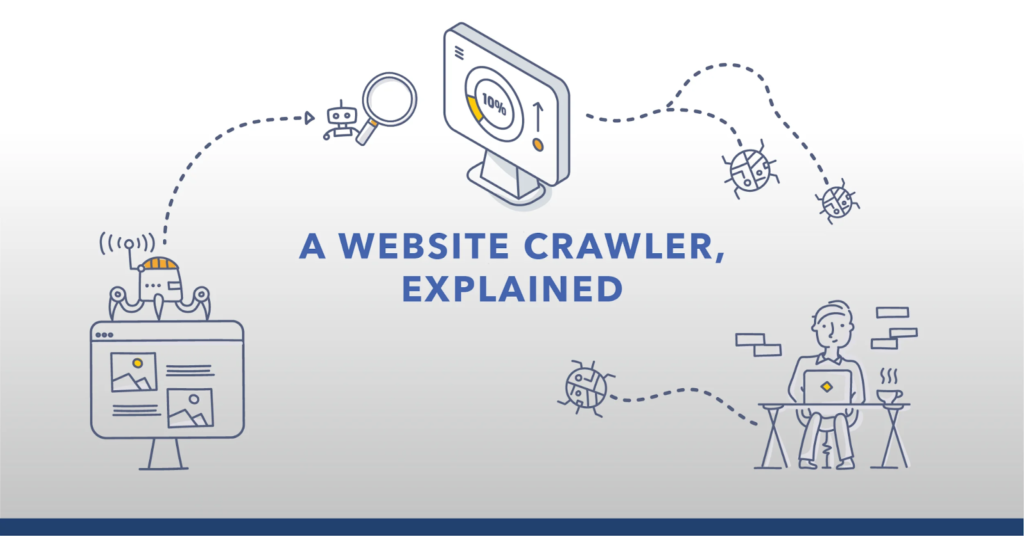

Los robots de rastreo de búsquedas web se están volviendo cada vez más inteligentes a medida que avanzamos hacia un futuro tecnológicamente más avanzado.

Según una encuesta, Los bots representaron más del 41% de todo el tráfico de Internet en 2021, y los bots dañinos representaron más del 25% de todo el tráfico.

Los editores o diseñadores web pueden detectar la actividad de los bots observando las consultas de red realizadas a sus sitios web.

La identificación de bots en el tráfico web se puede mejorar aún más mediante el uso de una plataforma de análisis integrada como Google Analytics.

¿Cómo puede Google Analytics detectar y bloquear el tráfico de bots?

Existen varios métodos sencillos para bloquear su sitio web. Tráfico de robots de Google Analytics. Aquí está la primera opción:

- Primero regístrese para obtener un perfil de Google Analytics.

- Vaya a la consola de administración de Google Analytics.

- A continuación, seleccione la opción Ver y luego Ver configuración.

- Para acceder a la opción Filtrado de bots, desplácese hacia abajo.

- Si la casilla de verificación no está marcada, presione Comprobar.

- Luego haga clic en Guardar.

La segunda opción es construir un filtro para bloquear cualquier actividad anómala que hayas encontrado.

Podrías crear una nueva Vista donde la casilla Bot esté deshabilitada y filtros que eliminen el tráfico malicioso.

Agregue el criterio a la Vista maestra después de verificar que sea funcional.

En tercer lugar, puede utilizar la Lista de exclusión de referencias, que se puede encontrar en el área de administración debajo de Información de seguimiento dentro del campo Propiedad.

Puede eliminar sitios de las métricas de Google Analytics utilizando esta lista. Como resultado, puede excluir cualquier URL (localizador uniforme de recursos) sospechosa de sus datos posteriores incorporándola a esta lista de verificación.

¿Cómo detectar la actividad de los bots en los sitios web?

1. Número de páginas vistas extraordinariamente alto

Los bots suelen ser los culpables cuando un sitio tiene un aumento abrupto, inesperado y sin precedentes en las visitas a la página.

2. Tasas de rebote extraordinariamente elevadas

La tasa de rebote es la proporción de visitantes que llegan a su sitio pero no hacen nada más mientras están aquí. Un aumento inesperado en las tasas de rebote puede significar que los bots han sido dirigidos a una página específica.

3. Duraciones de sesiones inesperadamente largas o cortas

El tiempo que los visitantes permanecen en un sitio se conoce como duración de la sesión. La naturaleza humana requiere que esto continúe siendo constantemente estable. Sin embargo, un aumento inesperado en la duración de la sesión probablemente se deba a que un bot navega por el sitio web con una lentitud inusual. Por otro lado, si la duración de la sesión es concisa, un bot puede rastrear páginas web mucho más rápido que una persona.

4. Conversiones de basura

El crecimiento en el porcentaje de conversiones falsas podría usarse para identificar conversiones basura, que se manifiestan como un aumento en la creación de perfiles con cuentas de correo electrónico ilógicas o la finalización de formularios web con un nombre, número de teléfono móvil y dirección falsos. Incremento de visitantes desde una ubicación sorprendente.

Otro signo común de actividad de bots es un fuerte aumento en el tráfico web de una región geográfica particular, especialmente donde es dudoso que los residentes nativos hablen el idioma utilizado para crear el sitio web.

¿Cómo se puede detener el tráfico de bots en los sitios web?

Una vez que una empresa u organización domina el arte de detectar el tráfico de bots, también es crucial que adquiera la experiencia y los recursos necesarios para evitar que el tráfico de bots dañe su sitio web.

Los siguientes recursos pueden reducir las amenazas:

1. Arbitraje legal

Pagar por el tráfico online para garantizar un alto rendimiento PPC (pago por clic) o iniciativas basadas en CPM (costo por mil) se denomina arbitraje de tráfico.

Los propietarios de sitios web sólo pueden minimizar las posibilidades de tráfico de bots maliciosos comprando tráfico de proveedores acreditados.

2.Robots.txt

Este complemento puede ayudar a evitar que bots maliciosos accedan a un sitio web.

3. Alertas con JavaScript

Los propietarios del sitio pueden agregar alertas de JavaScript relevantes para recibir notificaciones cada vez que un bot ingresa al sitio web.

4. Listas de DDoS

Los editores pueden reducir la cantidad de fraude DDoS compilando un inventario de direcciones IP (Protocolo de Internet) objetables y bloqueando dichos intentos de visita en su sitio.

5. Pruebas de respuestas a desafíos de tipo

Usar CAPTCHA en un formulario de registro o descarga es una de las formas más fáciles y populares de identificar el tráfico de bots. Es beneficioso para prevenir descargas y bots de spam.

6. Archivos de registro

El análisis de los registros de errores del servidor puede ayudar a los administradores web con sólidos conocimientos de métricas y análisis de datos a identificar y resolver fallas de sitios web relacionadas con bots.

Conclusión

El tráfico de bots no debe ignorarse porque puede resultar costoso para cualquier empresa con presencia en la web.

Aunque existen varias formas de limitar el tráfico de bots maliciosos, comprar una solución de control de bots dedicada es la más efectiva.

Biografía del autor: Atreyee Chowdhury trabaja a tiempo completo como gerente de contenido en un gigante minorista de Fortune 1. Le apasiona escribir y ayudó a muchas pequeñas y medianas empresas a lograr sus objetivos de marketing de contenidos con su contenido atractivo y cuidadosamente elaborado. Puedes seguirla en Etiqueta LinkedIn.