Al het niet-menselijke verkeer dat een site bezoekt, wordt botverkeer genoemd.

Uw website zal uiteindelijk bezoeken ontvangen van een specifiek aantal bots, of het nu een bekende nieuwswebsite is of een kleinschalig, onlangs gelanceerd bedrijf.

Botverkeer wordt vaak geïnterpreteerd als intrinsiek destructief; dat is echter niet altijd waar.

Het lijdt geen twijfel dat specifiek botgedrag vijandig bedoeld is en gegevens kan beschadigen.

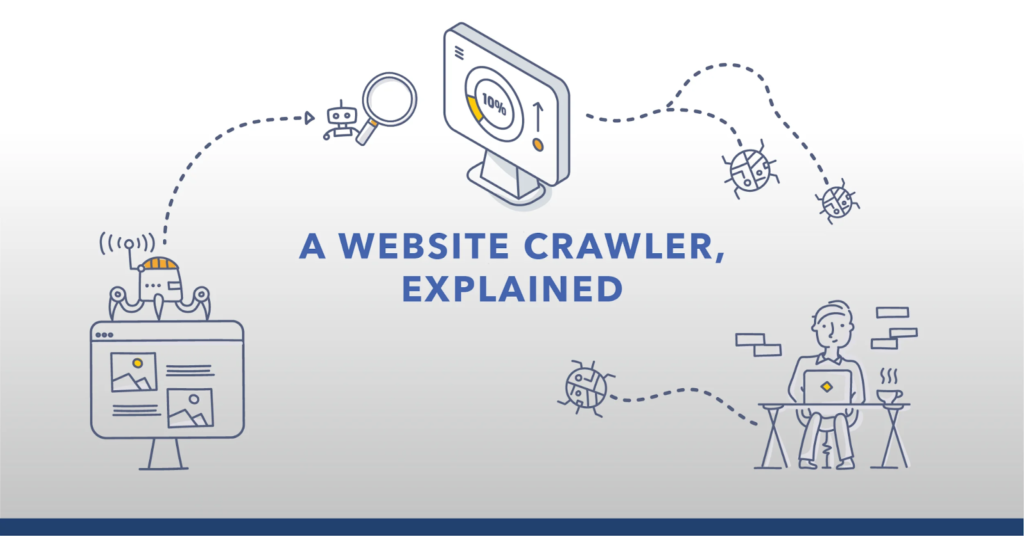

Webcrawlers kunnen soms worden gebruikt voor het verzamelen van gegevens, DDoS-aanvallen (distributed denial of service) of het opvullen van inloggegevens.

Bewezen strategieën voor het identificeren en verwijderen van botverkeer

Webexperts kunnen directe netwerktoegangsverzoeken naar websites onderzoeken om potentieel botverkeer op te sporen.

De detectie van botverkeer kan ook worden ondersteund door een ingebouwde webanalysetool. Laten we echter eerst eens kijken naar enkele cruciale informatie over bots voordat we de afwijkingen bespreken, die de onderscheidende kenmerken van botactiviteit zijn.

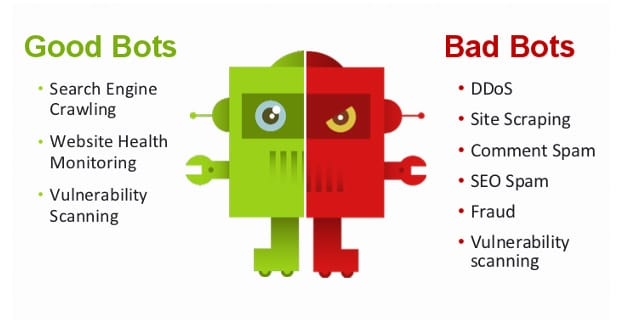

Wat is goed botverkeer?

De onderstaande bots zijn betrouwbaar en bestaan om nuttige antwoorden te bieden voor apps en websites

1. Bots voor zoekmachines

De meest opvallende en populaire goede bots zijn webzoekbots. Deze bots crawlen online en helpen site-eigenaren om hun websites weer te geven in de zoekresultaten van Bing, Google en Yahoo. Zij zijn handige tools voor SEO (zoek machine optimalisatie).

2. Bots monitoren

Uitgevers kunnen ervoor zorgen dat hun site veilig en bruikbaar is en optimaal presteert door bots te monitoren. Zij controleren of een website nog bereikbaar is door deze periodiek te pingen.

Deze bots komen ten goede aan site-eigenaren, omdat ze de uitgevers onmiddellijk op de hoogte stellen als er iets niet goed werkt of als de website uitvalt.

3. SEO-crawlers

SEO-crawlers gebruiken algoritmen om een website en zijn rivalen op te halen en te analyseren om informatie en statistieken te geven over paginaklikken, bezoekers en tekst.

Daarna kunnen webbeheerders deze inzichten gebruiken om hun inhoud te ontwerpen voor betere organische zoekprestaties en verwijzingsstromen.

4. Auteursrechtbots

Om ervoor te zorgen dat niemand ongeoorloofd auteursrechtelijk beschermd materiaal gebruikt, zoeken copyrightbots online naar foto's die door de wet zijn beschermd.

Wat wordt gedefinieerd als slecht botverkeer?

In tegenstelling tot de nuttige bots die we eerder hebben besproken, kan schadelijke botactiviteit uw site beïnvloeden en aanzienlijke schade aanrichten als deze niet wordt gecontroleerd.

De resultaten kunnen variëren van het leveren van spam of het misleiden van bezoekers tot meer ontwrichtende zaken, zoals advertentiefraude.

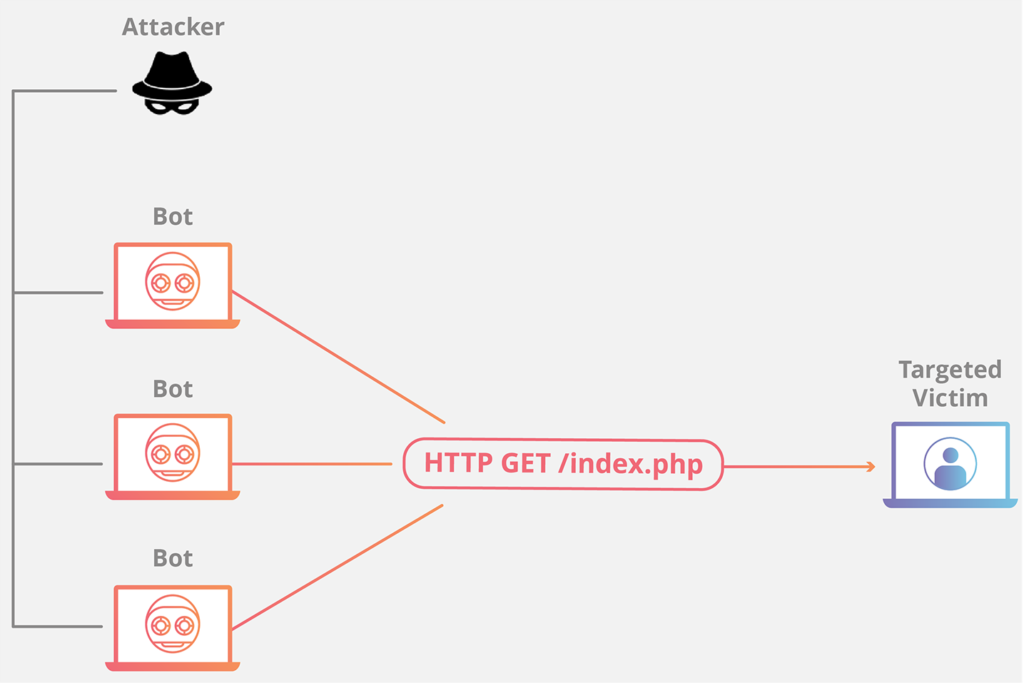

1. DDoS-netwerken

Een van de meest beruchte en gevaarlijke bots zijn DDoS-bots.

Deze programma's worden geïnstalleerd op de desktops of laptops van onwetende doelwitten en worden gebruikt om een bepaalde site of server neer te halen.

2. Webschrapers

Webschrapers schrapen websites voor waardevolle informatie zoals e-mailadressen of contactgegevens. In zeldzame gevallen kunnen ze tekst en foto's van sites kopiëren en deze zonder toestemming gebruiken op een andere website of sociale media-account.

Veel geavanceerde bots produceren schadelijk botverkeer dat alleen naar betaalde adverteerders gaat. Deze bots plegen advertentiefraude in plaats van de bots die ongewenst websiteverkeer genereren. Zoals de term suggereert, genereert dit geautomatiseerde verkeer hits op betaalde advertenties en kost het reclamebureaus aanzienlijk.

Uitgevers hebben verschillende redenen om botdetectietechnieken te gebruiken om illegaal verkeer, dat vaak wordt gecamoufleerd als regulier verkeer, uit te filteren.

3, Kwetsbaarheidsscanners

Talloze kwaadaardige bots scannen ontelbare sites op zwakke punten en stellen hun ontwikkelaars hiervan op de hoogte. Deze schadelijke bots zijn gemaakt om gegevens door te geven aan derden, die de gegevens vervolgens kunnen verkopen en gebruiken om digitale sites te infiltreren, in tegenstelling tot legitieme bots die de eigenaar waarschuwen.

4. Spambots

Spambots zijn voornamelijk gemaakt om commentaar achter te laten op een discussiethread op een webpagina die de auteur van de bot heeft gemaakt.

Hoewel CAPTCHA-controles (Completely Automated Public Turing Test to Tell Computers and Humans Apart) bedoeld zijn om de softwaregestuurde registratieprocessen uit te sluiten, zijn ze mogelijk niet altijd effectief in het voorkomen dat deze bots accounts aanmaken.

Hoe beïnvloeden bots de prestaties van websites?

Organisaties die niet begrijpen hoe ze botverkeer moeten herkennen en scannen, kunnen ze ruïneren.

Websites die goederen en grondstoffen aanbieden met een laag aanbod en afhankelijk zijn van advertenties, zijn zeer kwetsbaar.

Bots die websites met advertenties bezoeken en zich bezighouden met verschillende pagina-elementen, kunnen valse paginaklikken veroorzaken.

Dit wordt klikfraude genoemd, en hoewel het in eerste instantie advertentie-inkomsten kan opleveren, worden de website en de exploitant doorgaans uit hun systeem verwijderd zodra digitale advertentieplatforms de fraude identificeren.

Bots voor het oppotten van aandelen kunnen e-commercewebsites met weinig voorraad feitelijk afsluiten door karren met tonnen goederen te vullen, waardoor echte klanten geen aankopen meer kunnen doen.

Uw website kan vertragen als een bot regelmatig om gegevens vraagt. Dit houdt in dat de website voor alle gebruikers langzaam laadt, wat ernstige gevolgen kan hebben voor een internetbedrijf.

In extreme gevallen kan overmatige botactiviteit uw volledige website offline halen.

Crawlbots voor webzoekopdrachten worden steeds intelligenter naarmate we overgaan naar een technologisch geavanceerdere toekomst.

Volgens een onderzoek, bots vormden in 41 ruim 2021% van al het internetverkeer, terwijl schadelijke bots ruim 25% van al het verkeer voor hun rekening namen.

Webuitgevers of ontwerpers kunnen botactiviteit ontdekken door te kijken naar de netwerkquery's die op hun websites worden gedaan.

Het identificeren van bots in het webverkeer kan verder worden geholpen door een ingebed analyseplatform zoals Google Analytics te gebruiken.

Hoe kan Google Analytics botverkeer detecteren en blokkeren?

Er zijn verschillende eenvoudige methoden om uw website te laten blokkeren Botverkeer van Google Analytics. Hier is de eerste optie:

- Registreer u eerst voor een Google Analytics-profiel.

- Ga naar de Google Analytics-beheerdersconsole.

- Selecteer vervolgens de optie Bekijken en vervolgens Instellingen bekijken.

- Scroll naar beneden om toegang te krijgen tot de optie Botfiltering.

- Als het selectievakje niet is aangevinkt, drukt u op Controleren.

- Klik vervolgens op Opslaan.

De tweede optie is het construeren van een filter om afwijkende activiteiten die je hebt gevonden te blokkeren.

U kunt een nieuwe weergave maken waarin het Bot-selectievakje is uitgeschakeld en filters die kwaadaardig verkeer elimineren.

Voeg het criterium toe aan de Master View nadat u hebt gecontroleerd of het functioneel is.

Ten derde kunt u de verwijzingsuitsluitingslijst gebruiken, die u kunt vinden in het beheerdersgedeelte onder Trackinginformatie in het veld Property.

Met behulp van deze lijst kunt u sites verwijderen uit de Google Analytics-statistieken. Als gevolg hiervan kunt u verdachte URL's (Uniform Resource Locators) uitsluiten van uw vervolggegevens door ze op te nemen in deze checklist.

Hoe kan ik botactiviteit op websites herkennen?

1. Buitengewoon hoge paginaweergaven

Bots zijn doorgaans de schuldige wanneer een site een abrupte, onverwachte en ongekende toename in paginabezoeken heeft.

2. Buitengewoon hoge bouncepercentages

Het bouncepercentage is het percentage bezoekers dat op uw site terechtkomt, maar niets anders doet terwijl ze hier zijn. Een onverwachte stijging van het bouncepercentage kan erop duiden dat bots naar een specifieke pagina zijn gestuurd.

3. Onverwacht lange of korte sessieduur

De tijd dat bezoekers op een site blijven, wordt sessieduur genoemd. De menselijke natuur vereist dat dit voortdurend stabiel moet blijven. Een onverwachte stijging van de sessieduur is echter waarschijnlijk te wijten aan het feit dat een bot ongewoon langzaam op de website surft. Aan de andere kant, als de sessieduur beknopt is, kan een bot webpagina's veel sneller crawlen dan een persoon.

4. Conversies van rommel

De groei van het percentage valse conversies zou kunnen worden gebruikt om ongewenste conversies te identificeren – die zich manifesteren als een toename van het aanmaken van profielen met onlogische e-mailaccounts of het invullen van webformulieren met een valse naam, mobiel nummer en adres.5. Toename van bezoekers vanuit een verrassende locatie.

Een ander veel voorkomend teken van botactiviteit is een sterke toename van het webverkeer vanuit een bepaalde geografische regio, vooral waar het twijfelachtig is of autochtone bewoners de taal spreken die wordt gebruikt om de website te maken.

Hoe kun je botverkeer op websites stoppen?

Zodra een bedrijf of organisatie de kunst van het spotten van botverkeer onder de knie heeft, is het ook van cruciaal belang dat ze de expertise en middelen verwerven die nodig zijn om te voorkomen dat botverkeer hun website schaadt.

De volgende middelen kunnen bedreigingen verminderen:

1. Juridische arbitrage

Betalen voor online verkeer om een hoog rendement te garanderen PPC (betalen per klik) of op CPM (kosten per mille) gebaseerde initiatieven worden verkeersarbitrage genoemd.

Website-eigenaren kunnen de kans op kwaadaardig botverkeer alleen minimaliseren door verkeer van gerenommeerde providers te kopen.

2. Robots.txt

Deze plug-in kan helpen voorkomen dat kwaadaardige bots toegang krijgen tot een website.

3. Waarschuwingen met JavaScript

Site-eigenaren kunnen relevante JavaScript-waarschuwingen toevoegen om meldingen te ontvangen wanneer een bot de website betreedt.

4. Lijsten met DDoS

Uitgevers kunnen de hoeveelheid DDoS-fraude verminderen door een inventaris op te maken van aanstootgevende IP-adressen (Internet Protocol) en dergelijke bezoekpogingen op hun site te blokkeren.

5. Tests voor reacties op type-uitdagingen

Het gebruik van CAPTCHA op een aanmeldings- of downloadformulier is een van de gemakkelijkste en populairste manieren om botverkeer te identificeren. Het is nuttig voor het voorkomen van spambots en downloads.

6. Logbestanden

Het analyseren van serverfoutlogboeken kan webbeheerders helpen met sterke kennis van statistieken en data-analyse bij het identificeren en oplossen van botgerelateerde websitefouten.

Conclusie

Botverkeer mag niet buiten beschouwing worden gelaten, omdat het kostbaar kan zijn voor elk bedrijf met een aanwezigheid op het internet.

Hoewel er meerdere manieren zijn om kwaadaardig botverkeer te beperken, is de aanschaf van een speciale botcontroleoplossing het meest effectief.

Biografie van de auteur: Atreyee Chowdhury werkt fulltime als contentmanager bij een Fortune 1-retailgigant. Ze is gepassioneerd door schrijven en heeft veel kleine en middelgrote bedrijven geholpen hun contentmarketingdoelen te bereiken met haar zorgvuldig vervaardigde en boeiende inhoud. Je kunt haar volgen LinkedIn.